Sakana.aiの進化的モデルマージを記述した論文"Evolutionary Optimization of Model Merging Recipes" の論文要約メモです。

はじめに

今回まとめる論文はこちら:

- 2024/03/19 公開

- By Sakana AIのチーム

- コード: GitHub - SakanaAI/evolutionary-model-merge: Official repository of Evolutionary Optimization of Model Merging Recipes

なお本記事で掲載する図は全て上記論文からの引用です。

ではやっていきます。

The English translation of this post is here.

Evolutionary Optimization of Model Merging Recipes

概要

- 背景

- Model mergingはコスト効率の良いモデル構築手法として注目されている。

- 課題

- しかし、現在のModel mergingは人間の直感や経験、ドメイン知識に大きく依存した、いわば"黒魔術"である。

- やったこと

- 進化的アルゴリズムを用いてmodel mergingを行った。

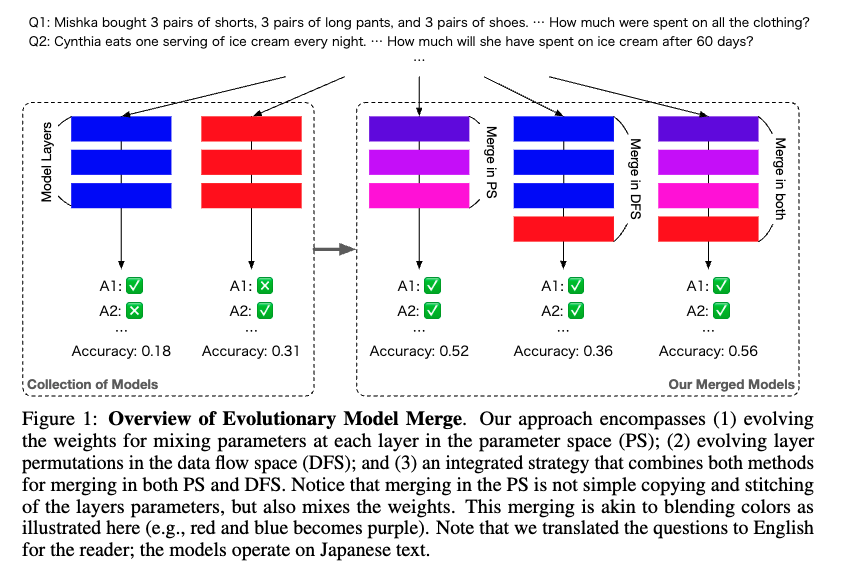

- PS: parameter space (重み)と、DFS: data flow space (レイヤー)の両方のアプローチを組み合わせた。

- 日本語モデル-数学的推論モデルのマージと、日本語VLMモデルの2パターンで実験した。

- 結果

- Cross-domainでのモデルmerge(日本語モデル-数学的推論モデル)により、既存モデルより優れた性能のモデルを作成できた。

- 日本の文化的文脈を含んだVLMタスクでも既存モデルを凌ぐ結果が出た。

手法

- PS: parameter space/重みレベルのマージと、DFS: data flow space/レイヤーレベルのマージ、そしてその両者を掛け合わせたマージを行う。

- PS mergeで使った手法

- TIES-Merging [2306.01708] TIES-Merging: Resolving Interference When Merging Models

- DARE [2311.03099] Language Models are Super Mario: Absorbing Abilities from Homologous Models as a Free Lunch

- 最適化に使った進化的アルゴリズム: CMA-ES The CMA Evolution Strategy: A Comparing Review | Springer Nature Link (formerly SpringerLink)

- DFS mergeで使った手法

- 進化的アルゴリズムでlayerを組み合わせる

- 全ての組み合わせを探索範囲に含めると天文学的な数字になってしまうが、事前調査でlayer順序の前後入れ替わりや繰り返しは悪影響であることがわかったため、その制約によって探索範囲を絞る。

- 隣接するlayerが変わると、inputの分散が変わってしまうので結果に悪影響が出る。Wを掛け合わせてinputをスケーリングすることでこの現象を緩和。Wも進化的アルゴリズムによる最適化の対象とする

- 最適化に使った進化的アルゴリズム: CMA-ES

- PS - DFSを組み合わせる

- 先にPS mergeをした後、そのモデルを使ってDFS mergeする

結果

LLMタスク

- MGSM-JA: 日本語での数学能力を測定するベンチマーク

- JP-LMEH: 日本語の汎用的な言語能力を測定するベンチマーク

- Merge元のモデル

- Model1: 日本語はできるが数学能力が低い

- Model2, 3: 数学能力にたけるが日本語能力が低い -> MGSM-JAの結果は良くない

- Merge後のモデル

- 総じてmerge元よりも結果が良い

- 特にModel4は異なるドメインのモデルをmergeして作ったわけだが、高い性能を発揮している

- PS mergeの方がDFS mergeよりも効果が高い

- PS mergeとDFS mergeの掛け合わせ(Model 6)でもさらに結果は良くなることもある(MGSM-JA)

VLMタスク

- JA-VG-VQA-500: 日本語での汎用的なVQA(Visual Question Answering)性能を評価するベンチマーク

- JA-VLM-Bench-In-the-Wild: 日本文化の文脈における複雑なVQA性能を評価するベンチマーク

- 上記2つのベンチマークはともに今回筆者らが新たに作成したもの

- Merge後モデルは、merge元のモデルよりも高い性能を示している

おわりに/所感

以上、論文"Evolutionary Optimization of Model Merging Recipes"の要約メモでした。

以下は私の個人的なメモです。

- 筆者たちは何を成し遂げようとしてるのか

- 人間の勘に頼っていたmodel mergeを、進化的アルゴリズムで自動化/高度化すること

- アプローチの鍵となる要素は何か

- 進化的アルゴリズムをmodel mergeに適用したこと

- 自分自身が活用できるものは何か

- 自動model mergeは持たざる者(GPU資源)にとって有用

- 次に読みたい引用論文は何か

- その他所感

- Backpropagationが実際の脳神経での学習で起きていることはないだろうが、model merging的なことなら起きてるんじゃないか。実際の脳神経での学習とは、脳内に構築されたモデル群の継続的なmergeプロセスなんじゃないか。そう考えるとワクワクする。

[関連記事]